C’est important de rendre accessibles les moyens de s’émanciper intellectuellement et techniquement…même si certains rament a s’en emparer…

D’ailleurs moi-même je ne comprends rien très régulièrement 😁…alors j’apprends…tout du moins j’essaie.

Ce genre d’initiative me parait être de l’ordre de l’intérêt public. Moins le web est soumis à la centralisation des données, à la Silicon valley et consorts, mieux il se portera…je dirais même mieux le monde se portera a mon humble avis…

Disons qu’on a la demonstration ces derniers temps, que quand tu laisses les manettes à des gens aux intentions discutables, l’équilibre mondial est mis à rude épreuve.

Du coup plus de manettes…plus de maitre, ni de dieu…😂

Actualités High-Tech

2.2k

Sujets

10.7k

Messages

-

[IPFS] Protocole Web permanent décentralisé

Planifier Épinglé Verrouillé Déplacé ipfs dev p2p décentralisé +0

1 Votes12 Messages909 Vues

+0

1 Votes12 Messages909 Vues -

Moltbook, le réseau social où les IA parlent entre elles (et où l’humain regarde)

Planifier Épinglé Verrouillé Déplacé3 Votes8 Messages90 Vues -

La pénurie persistante de RAM entraîne une deuxième hausse de prix du Raspberry Pi en deux mois

Planifier Épinglé Verrouillé Déplacé0 Votes9 Messages54 Vues -

Oui, Microsoft donne les clés BitLocker aux forces de l’ordre. Non, ce n’est pas nouveau

Planifier Épinglé Verrouillé Déplacé1 Votes1 Messages29 Vues -

Perquisition de X en France : Elon Musk convoqué pour une audition au tribunal !

Planifier Épinglé Verrouillé Déplacé2 Votes5 Messages43 Vues -

Vous passez de ChatGPT à Gemini ? Google vous déroule le tapis rouge

Planifier Épinglé Verrouillé Déplacé0 Votes1 Messages22 Vues -

Au cœur des efforts déployés par Nvidia pendant 10 ans pour faire de la Shield TV l'appareil Android le plus à jour jamais conçu

Planifier Épinglé Verrouillé Déplacé2 Votes19 Messages241 Vues -

En santé, les erreurs par omissions des LLM sont nombreuses et dangereuses

Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages32 Vues -

Apple, la pub et la vie privée : deux salles d’audience, une même ambiance

Planifier Épinglé Verrouillé Déplacé3 Votes4 Messages80 Vues -

Data centers : à l’Assemblée nationale, des appels à questionner la course au gigantisme

Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages43 Vues -

Quand une IA en contamine une autre: ChatGPT va chercher ses (mauvaises) réponses sur Grokipedia

Planifier Épinglé Verrouillé Déplacé3 Votes2 Messages65 Vues -

Des habitants de Norfolk, furieux, perdent leur procès visant à faire cesser la présence des scanners de plaques d'immatriculation

Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages31 Vues -

Nouveau téléviseur

Planifier Épinglé Verrouillé Déplacé0 Votes6 Messages111 Vues -

Vente de SFR : Orange est intéressée, mais on « est très très loin d’avoir un schéma d’accord »

Planifier Épinglé Verrouillé Déplacé2 Votes9 Messages361 Vues -

VoidLink, un nouveau maliciel Linux cible les environnements cloud et conteneurs

Planifier Épinglé Verrouillé Déplacé voidlink malware linux cybersécurité2 Votes1 Messages40 Vues -

Dès le 31 janvier, c’est le début de la fin du cuivre pour 26 000 communes (20 millions de locaux)

Planifier Épinglé Verrouillé Déplacé1 Votes21 Messages254 Vues -

Lancée dans une course de vitesse contre ses concurrents étrangers, Diamfab inaugure sa première ligne pilote de diamants semi-conducteurs en Isère

Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages38 Vues -

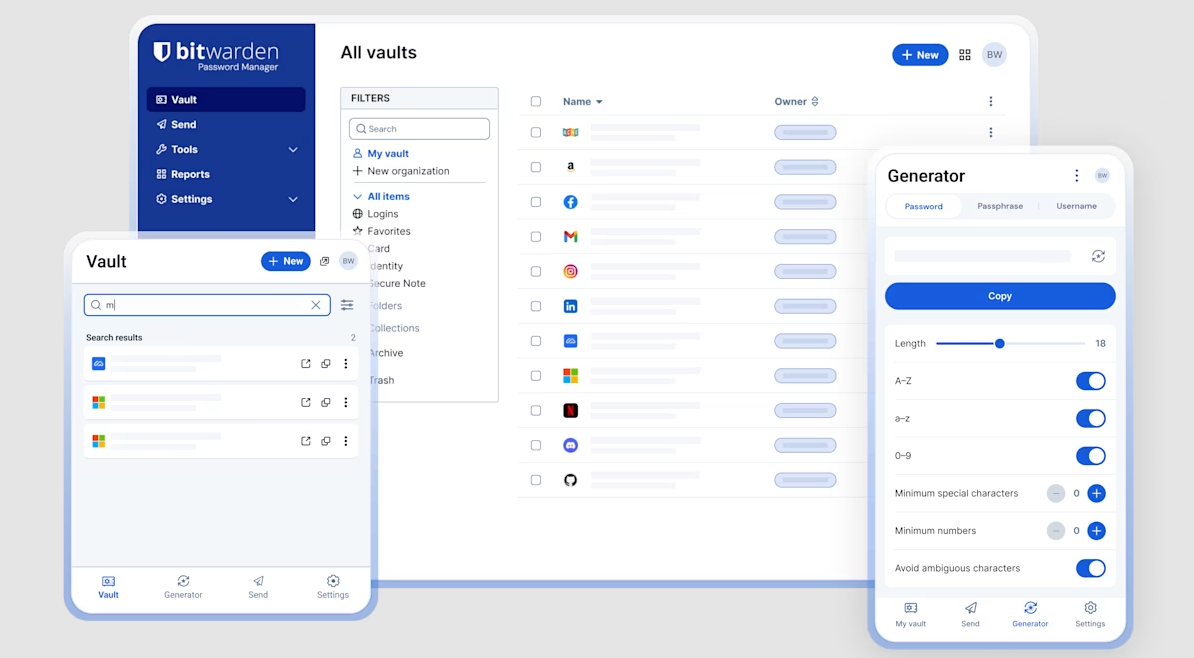

Bitwarden, Interview du PDG Michael Crandell

Planifier Épinglé Verrouillé Déplacé bitwarden michael crandell1 Votes1 Messages41 Vues -

Vos écouteurs Bluetooth peuvent vous espionner : la faille Google révélée par la KU Leuven

Planifier Épinglé Verrouillé Déplacé1 Votes6 Messages135 Vues -

OpenAI va lancer la publicité sur ChatGPT

Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages35 Vues

L'actualité Warez & underground en continu