ChatGPT a inventé une fonctionnalité de produit à partir de rien, alors une entreprise l'a créée à son compte

-

Lundi, la plateforme de partitions Soundslice a annoncé avoir développé une nouvelle fonctionnalité après avoir découvert que ChatGPT indiquait à tort aux utilisateurs que le service pouvait importer des tablatures ASCII , un format de notation de guitare textuel que l’entreprise n’avait jamais pris en charge. Cet incident constituerait ce qui pourrait être le premier cas où une entreprise crée une fonctionnalité en réponse directe à la fabulation d’un modèle d’IA.

Généralement, Soundslice numérise des partitions à partir de photos ou de PDF et synchronise la notation avec des enregistrements audio ou vidéo, permettant aux musiciens de voir la musique défiler au fur et à mesure qu’ils l’écoutent. La plateforme comprend également des outils pour ralentir la lecture et s’entraîner sur les passages difficiles.

Adrian Holovaty, cofondateur de Soundslice , a écrit dans un récent article de blog que le développement de nouvelles fonctionnalités avait débuté dans un mystère total. Il y a quelques mois, Holovaty a remarqué une activité inhabituelle dans les journaux d’erreurs de l’entreprise. Au lieu de télécharger des partitions classiques, les utilisateurs envoyaient des captures d’écran de conversations ChatGPT contenant des tablatures ASCII – de simples représentations textuelles de partitions de guitare ressemblant à des cordes avec des chiffres indiquant la position des frettes.

« Notre système de numérisation n’était pas conçu pour prendre en charge ce style de notation », a écrit Holovaty dans son billet de blog. « Alors, pourquoi étions-nous bombardés de captures d’écran de ChatGPT avec des onglets ASCII ? J’ai été perplexe pendant des semaines, jusqu’à ce que je me mette à utiliser ChatGPT. »

En testant ChatGPT, Holovaty a découvert la source de la confusion : le modèle d’IA demandait aux utilisateurs de créer des comptes Soundslice et d’utiliser la plateforme pour importer des tabulations ASCII pour la lecture audio, une fonctionnalité inexistante. « Nous n’avons jamais pris en charge les tabulations ASCII ; ChatGPT mentait carrément », a écrit Holovaty. « Et cela nous ternissait l’image, créant de fausses attentes quant à notre service. »

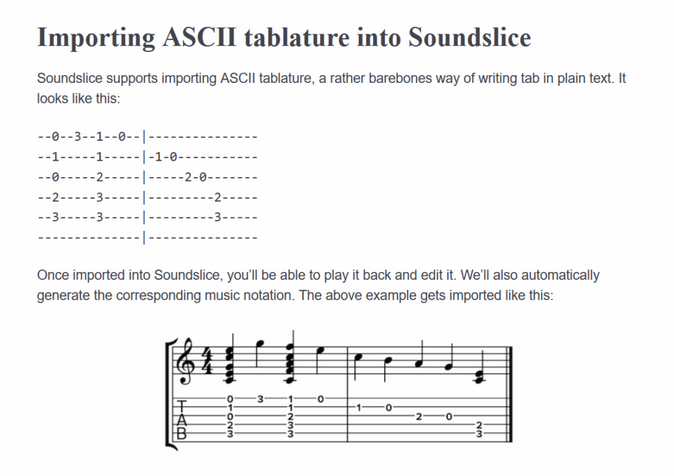

Une capture d’écran de la nouvelle documentation de l’importateur d’onglets ASCII de Soundslice, hallucinée par ChatGPT et rendue “réelle” plus tardLorsque des modèles d’IA comme ChatGPT génèrent de fausses informations avec une apparente confiance, les chercheurs en IA parlent d’« hallucination » ou de « fabulation ». Ce problème de fabulation de fausses informations est un fléau pour les modèles d’IA depuis la sortie publique de ChatGPT en novembre 2022, lorsque des utilisateurs ont commencé à utiliser à tort le chatbot comme substitut d’un moteur de recherche.

En tant que machines de prédiction, les grands modèles linguistiques entraînés sur d’importants ensembles de données textuelles peuvent facilement produire des résultats apparemment plausibles, mais totalement inexacts. Ces modèles improvisent statistiquement pour combler les lacunes de connaissances sur des sujets mal représentés dans leurs données d’entraînement, générant du texte basé sur des modèles statistiques plutôt que sur l’exactitude factuelle. Ainsi, ChatGPT a indiqué à ses utilisateurs ce qu’ils voulaient entendre en créant une fonctionnalité Soundslice logique, mais inexistante.

Habituellement, les affabulations causent des ennuis. Dans une affaire notable de 2023, des avocats ont été sanctionnés après avoir soumis des mémoires contenant des citations générées par ChatGPT à des affaires judiciaires inexistantes. En février 2024, le Tribunal de résolution civile du Canada a condamné Air Canada à verser des dommages-intérêts à un client et à respecter une politique tarifaire pour deuil, hallucinée par un chatbot d’assistance, qui indiquait à tort que les clients pouvaient demander rétroactivement une réduction pour deuil dans les 90 jours suivant la date d’émission du billet.

Du bug à la fonctionnalité

Cette découverte a placé Soundslice face à un dilemme inhabituel. L’entreprise aurait pu publier des avertissements avertissant les utilisateurs d’ignorer les affirmations de ChatGPT, mais elle a choisi une autre voie. « Nous avons fini par nous dire : tant pis, autant répondre à la demande du marché », explique Holovaty. L’équipe a créé un importateur d’onglets ASCII – une fonctionnalité qui figurait « en bas de ma liste des logiciels que je prévoyais de développer en 2025 » – et a mis à jour son interface utilisateur pour informer les utilisateurs de cette nouvelle fonctionnalité.

La solution de Soundslice présente un cas intéressant de limonade à partir de citrons, mais pour Holovaty, la situation soulève des questions philosophiques sur le développement de produits. « J’ai des sentiments mitigés à ce sujet », écrit-il. « Je suis heureux d’ajouter un outil qui aide les gens. Mais j’ai l’impression qu’on nous a forcé la main d’une manière étrange. Devrions-nous vraiment développer des fonctionnalités en réponse à la désinformation ? »